LLM4OR: L’AI Generativa che Traduce i Problemi in Soluzioni

Un progetto Deix per esplorare il potenziale dei modelli di linguaggio nell’ottimizzazione

Immaginate di dover risolvere un problema complesso, come organizzare la turnazione ottimale dei dipendenti in un’azienda, minimizzando i costi e rispettando tutti i vincoli di legge e produttività. Per un esperto di ricerca operativa, questo significa trasformare la richiesta in un modello matematico, con equazioni e vincoli precisi, per poi affidarne la soluzione a un software specializzato.

Ma cosa succederebbe se un’intelligenza artificiale potesse fare questa traduzione automaticamente?

Qui entra in gioco LLM4OR, il progetto di ricerca di Deix che esplora l’uso dei modelli di linguaggio (LLM) per interpretare un problema descritto in linguaggio naturale e convertirlo in un modello matematico pronto all’uso.

L’idea è tanto semplice quanto ambiziosa: possiamo insegnare a un’intelligenza artificiale a fare il nostro lavoro di analisi e formalizzazione?

Non per sostituire l’intelligenza umana, ma per renderla più efficace e veloce.

Come Funziona un LLM?

Un Large Language Model (LLM) come ChatGPT non "pensa" né "comprende" nel senso umano del termine. Non ragiona come un esperto di ottimizzazione che analizza un problema, riflette sulle sue implicazioni e formula un modello matematico consapevole del contesto.

Invece, un LLM è come un enorme completatore di frasi avanzato. Funziona associando sequenze di parole con altre sequenze statisticamente probabili, basandosi su tutto ciò che ha visto nei dati di addestramento.

Un’analogia utile?

Immaginate un turista in un paese straniero che non parla la lingua locale. Ha con sé una guida con frasi pre-tradotte: non comprende davvero cosa significano, ma sa che per chiedere il conto al ristorante deve dire “Il conto, per favore”. Se la situazione cambia leggermente (ad esempio, un cameriere gli chiede se vuole pagare con carta o contanti), potrebbe rimanere spiazzato.

Un LLM lavora in modo simile: non capisce davvero il problema, ma sa quale tipo di risposta è più probabile in base ai dati con cui è stato addestrato.

LLM per la Ricerca Operativa

Questo processo statistico può essere sorprendentemente efficace. Per verificare se un LLM può simulare la capacità di tradurre un problema di ottimizzazione in un modello matematico, abbiamo:

- scelto un modello open-source (Llama3-8B-Instruct) per valutarne l’efficacia rispetto ai modelli proprietari come ChatGPT,

- usato un dataset pubblico, contenente problemi di ottimizzazione già tradotti in modelli matematici, dando quindi al modello una serie di esempi chiari,

- creato un dataset personalizzato, con problemi più realistici e complessi per migliorare ulteriormente la capacità del modello,

- affinato il modello, facendogli “studiare” i nuovi dati per migliorare la sua capacità di traduzione.

Questa precisazione è importante: non abbiamo “insegnato” al modello a pensare come un esperto, ma lo abbiamo addestrato a riconoscere e riprodurre schemi di traduzione che funzionano.

Il risultato? Un sistema che è in grado di convertire problemi raccontati in linguaggio naturale in modelli matematici.

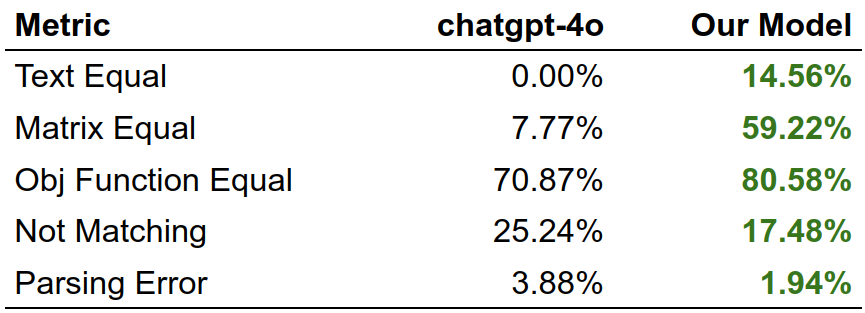

Abbiamo confrontato il nostro modello con ChatGPT-3.5 e ChatGPT-4o su un insieme di problemi, valutando:

- corretta identificazione delle variabili e della funzione obiettivo

- traduzione precisa dei vincoli matematici

- capacità di generare codice eseguibile per la risoluzione del problema.

Il nostro modello ha dimostrato migliori performance rispetto a ChatGPT-3.5 e, grazie al fine-tuning sui dati personalizzati, ha supertato le capacità di ChatGPT-4o.

Ma cosa significa questo nella pratica?

Significa che un utente potrebbe descrivere a parole un problema e ottenere automaticamente un modello pronto per essere risolto da un software di ottimizzazione.

Oggi il progetto è in fase sperimentale, ma le applicazioni sono molteplici:

- Supporto ai nostri esperti: in Deix, questa tecnologia potrebbe accelerare il nostro lavoro, riducendo il tempo necessario per la fase di modellazione iniziale.

- Integrazione in JINN, la piattaforma AI di Deix che permette la creazione di Agenti AI multi-purpose, include ore le funzionalità di creazione e fine-tuning di un modello dedicato a partire da un modello open source, non solo su problemi di ottimizzazione.

L’esperimento LLM4OR ha dimostrato che gli LLM possono supportare l’ottimizzazione, traducendo problemi in modelli matematici con crescente accuratezza.

🚀 Non si tratta di sostituire l’intelligenza umana, ma di potenziarla, fornendo uno strumento che velocizza e facilita il lavoro degli esperti.

💡 Per Deix, questa è una conferma della nostra missione: esplorare il potenziale dell’AI per creare soluzioni innovative e pratiche.

Ti interessa questa tecnologia?

Se vuoi saperne di più o collaborare con noi su questo progetto, contattaci a info@deix.ai.