L'uso dei Transformers per analizzare serie temporali

L'Importanza delle Serie Temporali

Le serie temporali sono alla base di molte applicazioni cruciali nel mondo reale. Dati finanziari, consumi energetici, dati sul comportamento degli utenti, misurazioni industriali e previsioni meteorologiche: tutti questi scenari generano informazioni strutturate nel tempo. Le serie temporali, infatti, rappresentano sequenze di dati rilevate in intervalli regolari e costituiscono una delle forme di dati più pervasive e preziose nelle applicazioni moderne. La loro analisi permette di comprendere fenomeni, individuare pattern ricorrenti e fare previsioni che sono fondamentali per decisioni strategiche in molti settori.

Nel contesto delle aziende, comprendere come un sistema si evolverà nel tempo o come una certa variabile influenzerà il comportamento futuro può fare la differenza tra successo e fallimento. Proprio per questo motivo, è fondamentale sviluppare modelli in grado di gestire e interpretare al meglio queste informazioni dinamiche, ed è qui che entra in gioco il potere dei modelli di IA avanzata, come i Transformers.

La rivoluzione dei Transformer

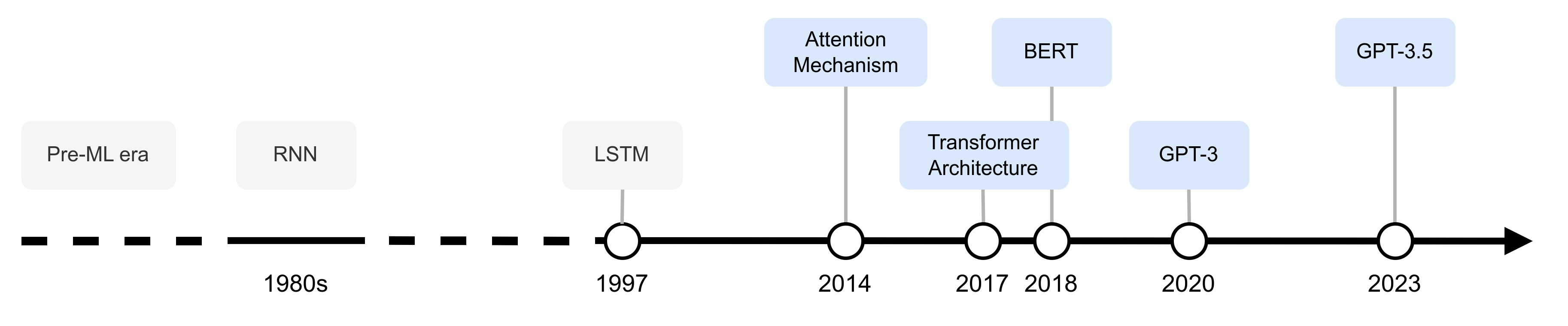

I Transformers sono un tipo particolare di rete neurale per elaborare sequenze di dati. Sono emersi come una delle innovazioni più significative nel campo dell'intelligenza artificiale negli ultimi anni, in particolare nella modellazione del linguaggio naturale. Introdotti per la prima volta nel 2017, questi modelli hanno rivoluzionato il modo in cui l'IA gestisce l'elaborazione del linguaggio naturale (NLP), dando vita a sistemi avanzati come i modelli di linguaggio di grandi dimensioni (LLM) - tra cui GPT, BERT e molti altri.

L'idea centrale dei Transformers è la meccanica dell'"attenzione", un meccanismo che consente al modello di focalizzarsi su diverse parti di un input in modo flessibile ed efficace. Grazie alla capacità di considerare simultaneamente le relazioni tra tutte le posizioni di una sequenza, i Transformers si sono dimostrati estremamente potenti nel catturare relazioni di lungo termine nei dati sequenziali, una caratteristica che li rende particolarmente adatti non solo per il testo, ma anche per l'analisi delle serie temporali.

Perché i Transformers per le Serie Temporali?

Le serie temporali possono essere viste come sequenze di dati che cambiano nel tempo, molto simili al modo in cui un testo è composto da una sequenza di parole. Tradizionalmente, modelli come le reti neurali ricorrenti (RNN) e le Long Short-Term Memory (LSTM) sono stati utilizzati per modellare le serie temporali, grazie alla loro capacità di mantenere una memoria temporale. Tuttavia, questi approcci hanno delle limitazioni nell'affrontare sequenze particolarmente lunghe o con dipendenze complesse.

I Transformers, grazie al meccanismo di attenzione auto-applicata, superano queste limitazioni fornendo una visione più ampia e contestualizzata dei dati. Con i Transformers, ogni punto di una serie temporale può essere messo in relazione con ogni altro punto, senza la necessità di percorrere la sequenza in modo rigido come nelle RNN. Questo consente ai Transformers di individuare rapidamente, e in modo automatico, pattern complessi, anche a distanza significativa nel tempo.

Embedding e Predizione: Come Funzionano i Transformers per le Serie Temporali

L'applicazione dei Transformers alle serie temporali prevede diversi passaggi fondamentali. Prima di tutto, le serie temporali vengono rappresentate tramite embedding, ovvero rappresentazioni numeriche dense che catturano le caratteristiche salienti delle sequenze. Questi embedding fungono da input al modello Transformer, che attraverso i suoi layer di attenzione riesce a identificare pattern, tendenze e relazioni tra i dati.

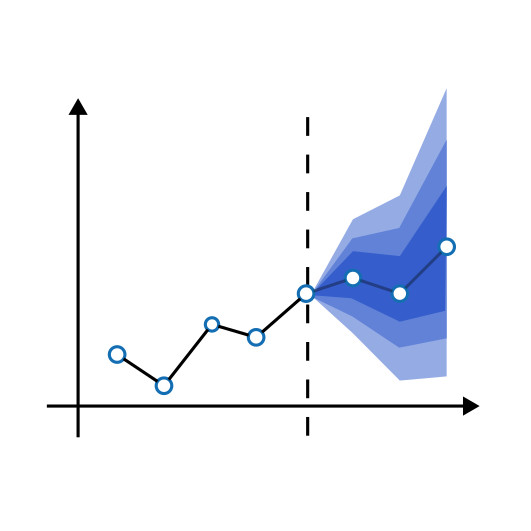

Questa rappresentazione, altamente informativa, può essere utilizzata alla base di layer di classificazione o di previsione, a seconda dell'obiettivo finale. Se l'obiettivo è classificare un evento (ad esempio, rilevare un'anomalia in una serie di dati industriali), gli embedding vengono utilizzati come input per un layer di classificazione. Se invece l'obiettivo è prevedere valori futuri (come le vendite mensili di un prodotto), gli embedding vengono utilizzati per un layer di previsione.

Grazie a queste caratteristiche, i Transformers permettono di affrontare una vasta gamma di problemi di analisi delle serie temporali, migliorando sia l'accuratezza delle previsioni che la capacità di interpretare e spiegare i fenomeni sottostanti. Inoltre, l'utilizzo di architetture basate su Transformers consente di integrare anche informazioni esterne o contesti diversi, aumentando ulteriormente la potenza dei modelli sviluppati.

Opportunità per le Aziende

L'utilizzo dei Transformers per l'analisi delle serie temporali rappresenta un passo avanti significativo rispetto ai metodi tradizionali. Grazie alla capacità di catturare pattern complessi e relazioni di lungo termine, questi modelli offrono nuove possibilità per la previsione e la classificazione dei dati temporali, rendendo più efficace l'applicazione dell'IA in contesti aziendali e industriali.

In Deix, abbiamo esperienza nell’utilizzo di questo approccio per la classificazione di dati finanziari al fine di riconoscere potenziali frodi e per la previsione di serie temporali provenienti da sensoristica IoT per stimare la vita utile rimanente di componenti industriali, ma le potenziali applicazioni sono ancora più vaste.

In un mondo sempre più orientato dai dati, comprendere e sfruttare appieno il potere delle serie temporali significa dare alle aziende strumenti concreti per migliorare la loro competitività e le loro capacità decisionali. I Transformers si pongono come una delle soluzioni più promettenti per affrontare queste sfide in modo innovativo ed efficace.